移动摄影,没性能圈那普适性的评价方法(性能与功耗),也没音频圈那么玄学,但却依然很“黑箱”,用户对操作过程一无所知,因此也攒下了很多误解和冷知识。

这次就为大家解答一些移动摄影的日常疑问和冷热知识,结合之前的《简单科普:计算摄影“算”的是什么?》科普食用,效果更佳 。知道之后,将获得“你已超越全国90%用户”认证。

镜头

手机镜头几乎都是塑料/树脂材质。

8P镜头的“P”,不是“片”的拼音缩写,而是Plastic的英文缩写,中文叫塑料或普拉斯提克。

1G6P镜头的“G”,是Glass玻璃的缩写。Redmi K40游戏增强版、vivo X70 Pro+、vivo X80 Pro、小米Civi 2等部分机器在用。

手机上用玻璃镜片,核心用处其实是降低厚度和降低装配难度,其次才是玻璃能耐高温可以上更多层镀膜。1G6P的效果与8P接近,但透光率更高、厚度更低,唯一缺点是贵。

联名与自研芯片

为什么松下CM1、华为、夏普、小米的手机都看不到徕卡的“可乐标”?这是徕卡的锅,其要求有可乐标就不能同时出现手机厂logo,所以大家只会用徕卡的文字标。

徕卡是多栖登陆的“渣男”,合作厂商不计其数,近代就有松下、华为、夏普、小米、Insta360、坚果投影、海信投影等等等等

OPPO其实也尝试过和蔡司合作,但没谈成,而徕卡则是被小米抢先了,最后只能和一加“共用”哈苏了(这条算八卦)

2005年,诺基亚N系列开山之作N90就首发了卡尔蔡司镜头,比2021年带蔡司小蓝标的vivo X60系列早17年。

华为和徕卡分手后,出了自己的影像品牌XMAGE,有人说是手机厂推翻相机联名的大山。但其实诺基亚在2012年初就有自己的影像品牌PureView(纯景),首发机型就是大名鼎鼎的怪物——诺基亚808 PureView。

为了计算摄影,Google在2017年的Pixel 2系列上,搭载了和英特尔合作设计的Pixel Visual Core,同代的还有华为海思的NPU、增加“仿生后缀”的苹果A系列芯片,多年后的vivo V1+、OPPO马里亚纳X,它们的初始核心用途全是搞计算摄影。

自研ISP,以前属于一个听起来那么高档的范畴——外挂ISP。不要怪各大厂都搞自研ISP,因为高通、联发科的集成ISP,性能真的不够用。

2012年的HTC One X就有ImageChip图像芯片(能每秒5张连拍、一次99张连拍、录像时也能拍照),比vivo、OPPO、小米的自研ISP/NPU早了8年有余。

传感器

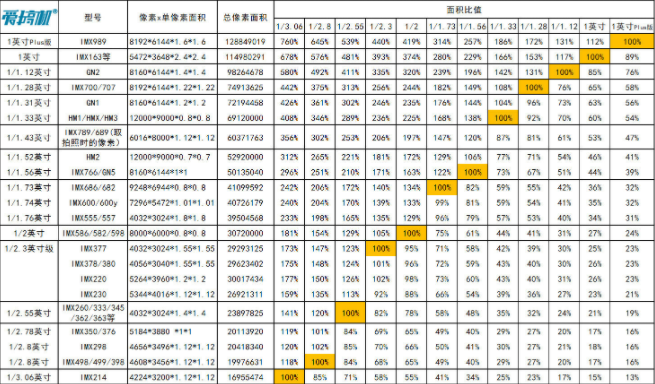

主流传感器的尺寸比例对比↑

数码相机,是胶卷相机大佬柯达在1975年发明的,最后把自己干趴了。

2019年主流的1/2英寸传感器IMX586,只比2018年主流的1/2.3英寸传感器IMX363大5%(因为在1/2.3英寸上下,“每英寸”分别对应16mm和18mm)。

同样是1/2.3英寸,不同CMOS间有14%的面积差异(ImX377对IMX230);同样是1英寸,不同型号间也有12%的差别。

弱光噪点主要由蓝色像素贡献。裸片硅在可见光波段的光电转换率是峰值的20%-60%,对1000nm红外光达到峰值,另一端的蓝光只有峰值的15%。

传感器不能无限做小,因为红色光波长范围在620–750nm(即0.62到0.75μm)之间,亚波长尺寸的子像素,效果会下降很明显。

现在最小的单位像素尺寸已小于理论极限。三星2亿像素的HP3传感器,单位像素已经压缩到了0.56μm,豪威也有同尺寸的传感器,但现在都没有量产机搭载。好消息是,这些传感器默认都是4合1、9合1输出,日常等效1.12μm和1.68μm,离物理瓶颈还很远,但高像素模式就基本废了。

同是0.64μm的2亿像素HP1、1亿像素HM6、5000万像素JN1,都是各自像素级别的耻辱,0.56μm的效果真的不堪设想。

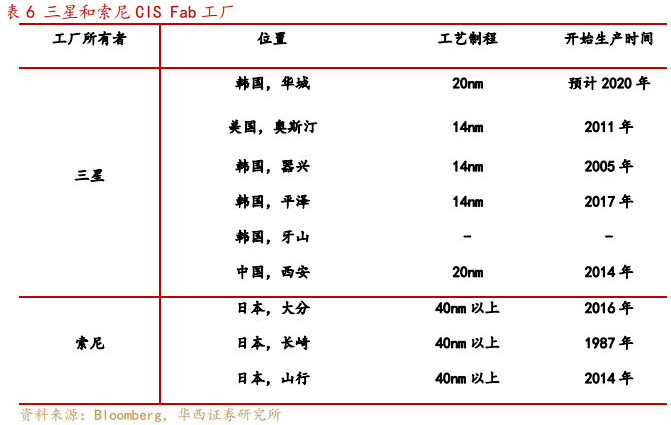

索尼传感器最小的单位像素尺寸是0.8μm(IMX586/582/598、IMX686/682、IMX709/787等),为何索尼没有像三星和豪威那样跟进小像素?因为索尼工厂的制程太落后,无法低成本地把CMOS的单位像素做小(三星和索尼核心传感器都是自己生产的,豪威和索尼部分产线是找代工)。以公开信息中的豪威Purecel Plus传感器为例,单位像素1μm用的是45nm工艺,0.8μm用的是28nm,然而索尼自己的厂,集中在40nm以上……

传感器是色盲,只能感知光线强弱,不能分辨颜色。实际操作中,是用红绿蓝3颜色的滤光片(对应常见的RGGB拜耳阵列,但也有RYYB等其他方案),让单个像素记录3原色中的一个,牺牲了2/3的像素数量去换取记录颜色的能力。结果100万像素的屏幕会有300万个子像素,而100万像素的CMOS只有100万个“子像素”。我们平时看到的照片,2/3的信息都是去马赛克(Demosaicing)算法插值、猜色重建的结果。

现代传感器滤光片最常用的Bayer拜耳阵列,就是柯达科学家Bryce Bayer发明的。

但滤光片排列在理念上没有所谓的最优解。最普遍的RGGB排列(也有比较常用的GBRG/GRBG/RGGB,优势是几十年的积累,色彩准、易调,但光线损失大)、有华为在用的RYYB(Y是黄色的意思,进光量大,但易偏红和高光溢出)、OPPO爱用的RGBW(W是白色,即无滤光片,进光量大,但色彩淡)、RWB(索性绿色都由无滤光片的白色代替,色彩也是问题)、MONO(黑白,最大进光量,但黑白)。

ToF镜头(Time of Flight,飞行时间)没那么高逼格。当年的激光对焦就算是ToF的一种,2014年的LG G3就有了,后来华为P9、HTC M10等大量机型使用(当年意法的ToF传感器有效距离只有2米),后因双核对焦普及而逐步被没落。更low的ToF实现,是距离感应器(控制打电话和口袋里自动灭屏那个),2016年的iPhone 7就在用了。

算法/计算摄影

手机上的计算摄影并没有那么遥不可及,本质还是把相机老法师手动/半自动的拍照方法和后期修图,进行自动化和硬件化。

以前手机拍照会有黑屏“咔嚓”一下的原因(现在基本不存在了):CMOS有预览和拍照模式,为了省电和降低ISP压力,前者可能是1080P,甚至可能是720P的。按下快门那下短暂黑屏,是CMOS转去拍照模式,导致预览视频流短暂中断的结果。

几年前,Google相机能移植到各种手机上(成为小米6的“最后一块拼图”),是因为当时后期处理管线对硬件依赖不强,基础版本只要支持Neon就能跑,但非官方设备没有对应的校正(降噪模型等),可能会出现涂抹力度过轻或过重、偏色、还无法达到最佳的效果。

现在大部分自动夜景的样张,其exif信息中的快门时长不再有参考性(几秒钟的夜景,结果快门显示1/4秒)。其显示的不是多帧合成的总时长,而是长曝光帧EV0正确曝光的样张快门速度。

HDR算法会降低细腻材质的质感(如毛发、线条等密集纹理),多帧合成的帧数越多,翻车几率越大,所以Google和很多厂商在光线好时,HDR是2帧合成的(苹果Smart HDR是9张,Google HDR+是2-8帧)。

虽然现在流行自研拍照算法,但算法供应商依然是大头。著名供应商有虹软科技(100亿市值,21年营收5.7亿,2.7亿研发,444人研发)、商汤(300亿市值,2000人)、旷视科技(市值200亿,总数1400人)、Core Photonics(以色列,市值2.5亿,50人研发)和 Morpho(日本,研发人员未知,7.6亿市值)

手机拍照算法值多少钱?在虹软19年财报曾有提及,计件模式下,平均每台手机算法费用0.55元……

日常使用

为什么相机一开,后台的app就没了?

因为相机app真的很吃内存。手机大厂为了做多帧合成+零延时延时快门,相机打开后就在不停拍照,按下快门后会把最近的2-15帧送去做多帧合成(苹果Smart HDR和Deep Fusion一般都是9张)。跑进RAW域(笼统理解为,从jpg文件到RAW文件)的图片处理流程,加上各种算法模型,以及部分机型那机关枪一样的快门响应,内存不爆就有鬼了。

反过来,要不是计算摄影巨大的内存需求,抠到家的苹果也不会让iPhone从2017年的3GB涨到现在的6GB。这样骗自己,心理会舒服点(苹果只用9合1,没有往上堆,一来是功耗和内存顶不住,二来是边际效用递减,以及样张太多就更难对齐,容易糊片)

都说安卓拍照比苹果好,但为什么安卓机发的朋友圈比苹果差?因为张小龙。安卓版微信对图片压缩更猛、分辨率更低。张小龙!!!

安卓第三方app拍照或录视频不如原生相机好?因为第三方app(包括用微信内置的拍照和录像入口)无法/没去调用原生相机的算法,甚至会用预览画面来输出视频,不糊才有鬼(因此改善第三方app的影像效果,也成了2017年Google Pixel Visual Core、2021年OPPO马里亚纳X等外挂芯片的目标之一)。

拍视频的视野为何比照片小?因为录像没调用所有像素,以常见的4:3 1200万像素传感器为例,4K 16:9(比例这里损失一道)录像单帧只用了1200万像素中的829万像素,8K视频只用了4800万模式中的3318万像素,视野自然会小一圈。理论上可用合并采样、超采来避免视角缩水,但算力和功耗要求太高。

近几年所有旗舰手机,连拍时都可能因为处理不及而偶尔出现几张没算法处理的“废片”,俗称“夹生”。

iPhone情况很轻微,但安卓旗舰比较明显,连拍或抓拍时,要珍惜前几下快门,前面都拍不清,后面大概率也是糊的。

即便是在2022年,绝大部分安卓旗舰,都会因为发热问题,根本无法坚持30分钟的4K 60fps录像(效果就更别提了)……而相机的30分钟视频拍摄限制,不是防止过热,而是避免进出口时被归类到摄像机,后者的关税更高(虽然确实有不少相机会过热)。